はじめに

こんにちは!開発本部所属のエンジニアの id:kiryuanzu です。

9月8日(木) 〜 9月10日(土) にRubyKaigi 2022が開催されました。

今回弊社ではシルバースポンサーとして協賛し、3名のエンジニアがオフラインで RubyKaigi に3日間通して参加しました。本記事では参加メンバーによる感想レポートをお送りします。

参加する前

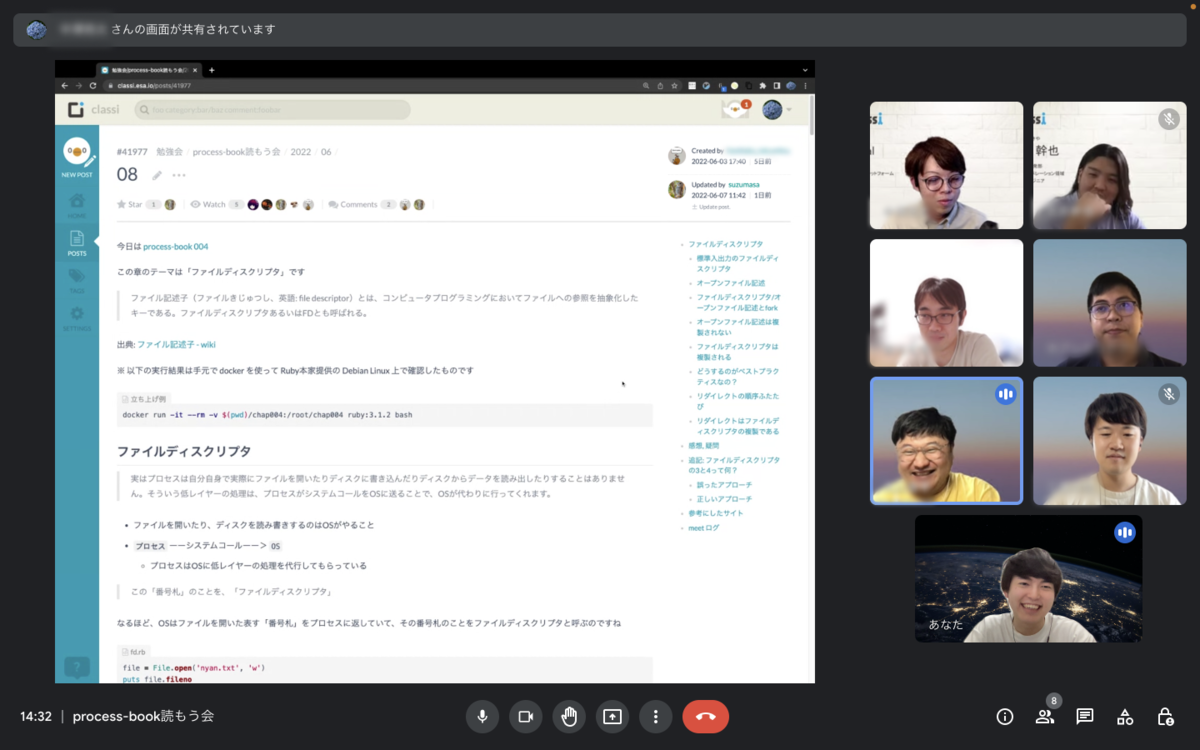

筆者自身は学生時代に何度かオフライン参加を経験したのですが、同行した2名の新卒エンジニアは今回が初参加となりました。行く前にできるだけ RubyKaigi がどんなものか知っておこうということで、開催1ヶ月前から igaigaさんによるプログラム解説を実施していただき、発表される内容の予習を行いました。

他にも、津の気になる飲食店をみんなで探して事前に予約したり、会ってみたい他社のエンジニアさんや OSS開発者の方について話すといった活動をやりながらイベント当日を心待ちにしていました。

当日の様子

1日目最初の発表から Ruby の WebAssembly でブラウザで動かすといった視覚的にもインパクトが強く今後身近に使われそうな機能の紹介と内部の実装の解説から始まり、自分含めたメンバーみなとても興味津々で聞いていました。発表後に「楽しそう、使ってみたくなった!」と「実装の話難しかったけどわくわくした……!」という感想をみんなで語り合うことができRubyKaigi ならではの会話だなと思いました。

現地にはいなかったメンバーの方も Slack 上での RubyKaigi 談義に花を咲かせており、過去に参加した先輩メンバーから「自分もわからない話が結構ある。だけど、内部実装の話とかめっちゃ面白いので今はわからなくても来年はわかるようになりたいと思えて何を勉強したらいいだろうと考えられる。だから、わからないけれど面白そうな話に出会えただけで価値があるよ」とアドバイスをもらいました。わからないことだらけであっても前向きに学ぼうと考えることができ、参加したメンバーにとって勇気をもらえるメッセージで印象に残りました。

イベント中では様々な他社の人にお会いし交流することができました。その中でも、筆者が個人的に印象に残っている出来事はエス・エム・エスさんの社員の方達と交流したことです。Classi に今在籍されている方で、以前エス・エム・エスさんで働いていた方がいたことがきっかけで会話が弾み、当時の思い出やどんな活躍をされていたかといった話題で盛り上がりました。

他にも、エス・エム・エスさんの社員さんの中には Classi ユーザーの方もいて機能の気になるところについて教えてもらうといったことがあり、想定していないところでユーザーの声を聞けて大変楽しかったです。

社員のみなさんと一緒に写真も撮っていただきました。

また、業務中に技術記事を探している時によく名前が出てくる方や新卒研修に入っていた課題図書を翻訳されている方など、会ったことはなかったけれどお世話になっていた方々 のお顔を拝見することができたのもRubyistが集まるイベントならではといった体験でメンバー一同とても刺激を受けることができました。

ご飯の方面でも大変満足な日々を送ることができました。参加したメンバーの @_da1kong が美味しそうな写真を撮ってくれたので一部公開します。

1日目夜は津駅周辺にある松重というお店に行きすき焼きを食べました。前菜含めて素敵なお味でした。

2日目は Ruby コミュニティでお世話になっている方達と一緒に竹屋牛肉店というお店に行きました。新卒メンバーが肉だけでなくご飯大やガーリックライスも注文していて大変良い食べっぷりだったのが印象に残っています。

他にも、泊まったホテルでは毎朝まむし丼(鰻が使われたご飯料理)、運営の方達が用意してくださったお弁当など毎日美味しいものをいただきました。

運営のみなさん、素敵なお店に連れて行ってくれたRubyコミュニティの方々、そして今回のイベントに行く際「せっかくなのだから美味しいものを食べてほしい」と快く出資してくださった先輩メンバーに改めて感謝の気持ちを伝えたいです。

ここからは新卒エンジニア2人による感想パートです。

@_da1kong さんの参加レポート

2022年4月から新卒エンジニアとして入社しました @_da1kongです。

このような大きいカンファレンスのオフラインでの参加はかなり久しぶりでした。

参加する中で特に印象深かったことについて報告します。

発表

カンファレンスの発表はかなり難しいものも多かったのですが、会社で予習して取り組んでいたおかげでより多く吸収することができました。

魅力的な発表は多くありましたが、そのなかで自分が特に印象に残った発表に触れたいと思います。

他の発表は予習をしていたのですが、この発表だけは「調べないで見た方がいい!」と言われていたので準備しないで臨みました。

内容はすごく読みにくいコードや芸術性の高いコードを紹介するもので、シンプルにプログラミングのアイデアの面白さを感じられる内容でした。

プログラミングに初めて出会った時のような新鮮な気持ちを思い出す発表で、オフラインイベントならではの盛り上がりに興奮しました。

社内でも演者のしおいさんが書いた記事をおすすめされることも多く、一方的にお世話になっている方でした。

Wiresharkというnetwork packet analyzerをmrubyで動かせるようにしたという内容で、個人的に関心のあるCTFで使用されているツールだったので興味のある内容でした。

機能が足りないと思ったら自分で作る!というエンジニアの気概を感じて楽しかったです。

また、観客とのコミュニケーションが活発でコミュニティからの愛を感じる発表でした。

Stringのエンコーディングの速度を改善していくという発表でした。

問題提起からボトルネックを見つけ改善するという、探索的に進めていく過程がまとまっていて、すごく勉強になりました。

ちょうど業務でサービスのパフォーマンスの改善をやっていたこともあり、親近感を感じる発表でした。

そのほかにも魅力的な発表は多くありましたが、中には難しいものも多かったです。

ただ、「なんか面白そう!」「来年は理解できるようになりたい!」というモチベーションが湧くものが多かったです。

RubyKaigiでの発表がすぐに日常の仕事に活かせるかは分かりませんが、純粋に技術を楽しむ気持ちやそれを試したくなる好奇心を感じることができました。

交流

このようなオフラインのイベントでは、休憩時間やお昼休みで実際にコミュニケーションができる時間が多くありました。

Rubyコミュニティの方々は良い意味ですごく砕けていて、楽しく話しやすい方が多かったです。

以前からRubyKaigiに参加されているid:kiryuanzuさんが繋いでくださって、本当に多くの方と交流させていただきました。

人生で初めての名刺交換もできました。

クリアコードの方と名刺交換した筆者

また以前Classiで特別講義をしていただき、RubyKaigiを主催しています松田さんにも直接お礼を言うことができました。

自分と同じぐらいの若手エンジニアから、世界で活躍するようなトップエンジニアまで分け隔てなく交流できるのは、このようなカンファレンスならではだと感じました。

エンジニアとして頑張るモチベーションが上がる充実した時間になりました。

まとめ

このような大きいカンファレンスは初めての参加で不安もありましたが、会社の先輩方やRubyKaigiに参加されていたエンジニアや運営の方々のおかげでとても有意義な時間となりました。

今回の参加で満足せずに、引き続きRubyコミュニティに参加していきたいという気持ちが強くなりました。

貴重な機会を頂きありがとうございました。

すずまささんの参加レポート

こんにちは!新卒1年目のすずまさです。

今回 RubyKaigi 初参加で、こういった技術カンファレンス自体も初めてでした。

また、入社してから Ruby を触り始めたので、Ruby 歴も半年未満と浅く、界隈に知り合いがたくさんいるわけでもないので、行く前は緊張と不安が少しありました。

行ってみた印象

印象を一言で表すと「面白くて質の高い大学講義 兼 大規模オフ会」でした。 参加する前に抱いていた不安は杞憂で、実際始まってみると私のような Ruby 初心者でも共感できたり、勉強になる発表が多かったです。

また、何度も参加されている id:kiryuanzu 先輩が引率してくださったおかげでたくさんの方と交流できました。 みなさん初対面でも優しく朗らかで、普段の仕事の話や趣味の話もできてとても楽しかったです。

弁当待ちで並んでいる Matz さんと津餃子の話をしたりもしました(笑) まさかこんなに気軽に話せるとは思っていなかったので面白かったです!とても気さくで優しい方でした!

印象に残った発表はたくさんありますが、特に記憶に残ったものを 3 つ紹介しようと思います。

Ruby meets WebAssembly

1 日目の一番最初に見たのがこの発表でした。

WebAssembly を使って Ruby をブラウザ上で動かすという話で、実演が多くすごさがわかりやすかったので、私も含めて会場全体が盛り上がっていました。

後半の実装の話は正直難しくてあまり理解できませんでしたが、「よくわからないけどすごい…!!」という感動が味わえて、この後の発表へのわくわく感が溢れてきました。

Create my own search engine.

ポケモンカードの検索エンジンを作った話をされていました。

技術的にも勿論おもしろいのですが、趣味が前面に出ておりとても楽しそうに話をされていたのが印象に残っています。

趣味で開発して未完成のままやめてしまったプロジェクトがあるので、この発表に感化されて久しぶりにまた再開したくなりました。

The Better RuboCop World to enjoy Ruby

RuboCop で遭遇しがちな問題点を整理し、それに対してこうすればもっと良くなるんじゃないかという話をされていました。

初心者にありがちな悲劇として「RuboCop に怒られたので通るようにメソッドを分けました!」という例が挙げられていたのですが、まさに自分が最近通った道だったので耳が痛かったです。

私のような Ruby 初心者から熟練者まで共感できるポイントのある、とても良い発表でした。

感想

私がプログラミングを始めてからの大半の時間はコロナ禍でオンラインになっていたので、こういったオフラインのイベントはとても新鮮で楽しかったです。

初めてで経験も乏しい中ここまでちゃんと楽しめたのは間違いなく先輩たちのお陰なので、本当に感謝の気持ちでいっぱいです。

交流する人たちもすごい人ばかりだったので非常に刺激を受けました。 発表に関しては理解が追いつかないことがかなり多かったので、次回までにもっと強くなって完全に理解できるようになりたいです!

終わりに

以上が新卒2人の感想パートとなります。2人とも最初は、オフラインのカンファレンス参加の経験が少なく不安な面もあったようでしたが結果的にすごく楽しんでいただけたようで何よりです。

今回の RubyKaigi では筆者含めて参加メンバーみな刺激を受けたイベントになりました。この経験を経て、次に勉強したいことや挑戦してみたいことなど、新たな目標がたくさん生まれたように思います。

次回に向けて、RubyKaigi の良さを周知する活動を続けることで一緒に参加するメンバーを増やせたらと考えています。

それでは、来年の松本でまたお会いしましょう!読んでいただきありがとうございました。

最後に、Classi では一緒に働いてくれるメンバーを絶賛募集中です!Ruby を書くのが好きな方、教育サービスに携ることに興味がある方など、ぜひご連絡いただけると幸いです。