こんにちは。技術戦略室にてエンジニアをしています、中島です。

以前、リモートワーク環境におけるコミュニケーション課題の一つである「質問」についてブログを書かせていたただきました。 tech.classi.jp

弊社では今でも全社的にフルリモートを続けていますが、やはり人と人との接触機会は以前より減っています。そのため、計画的偶発性も少なくなっているのではないか、と考えています。

※ 計画的偶発性とは?

個人のキャリアの8割は予想しない偶発的なことによって決定される。その偶然を計画的に設計し、自分のキャリアを良いものにしていこうという考え方。 計画的偶発性理論 - Wikipedia

今回は、こういった状況を改善するために始めてみた施策について紹介します。

開発本部の課題と仮説

施策の内容へ入る前に、今私が所属している開発本部の抱えている課題と、それに対する仮説をお伝えします。

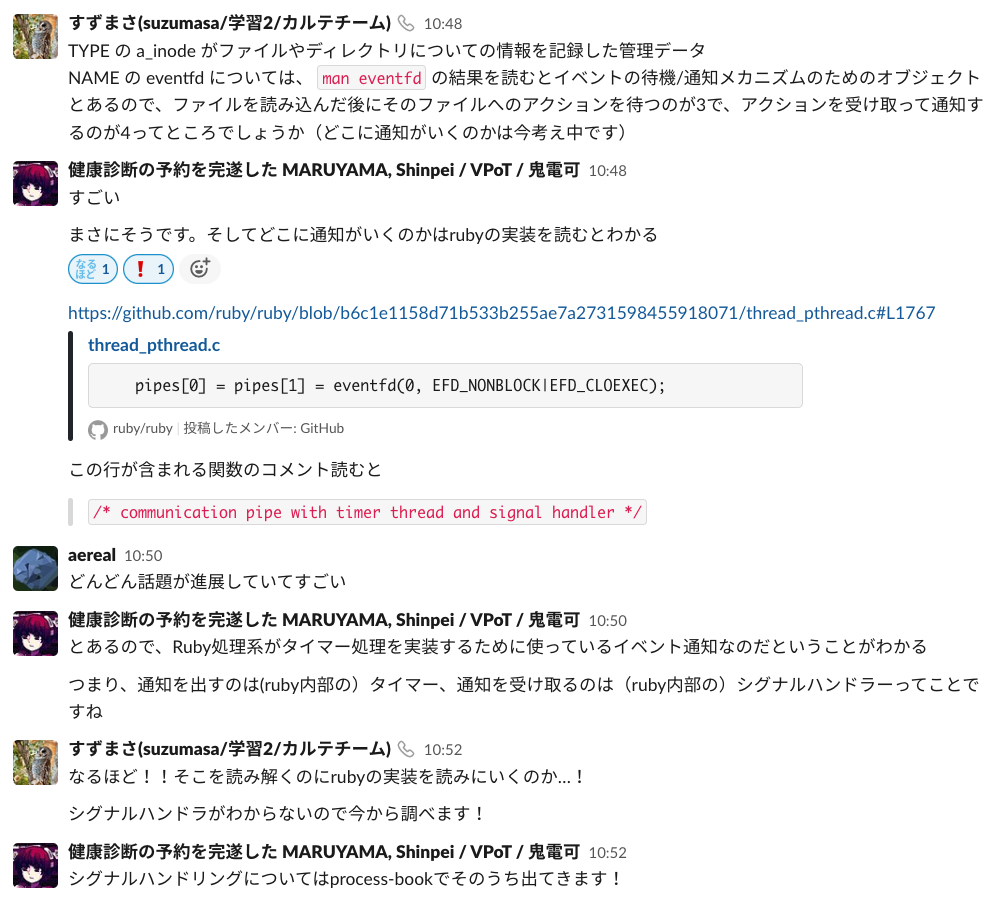

「Classi」というサービスはユーザー様から見ると1つのサービスですが、その中には先生・生徒・保護者様向けに様々なサービスが存在します。 classi.jp

開発チームはそれぞれのサービス毎に存在していますが、サービス内の機能は他のサービスとも複雑に依存しあっています。そのため、ちょっとした修正、お問い合わせの調査、システムアラート対応などをするだけでも他のチームとのコミュニケーションが必要になります。

しかし、チームを越えてコミュニケーションを取ることが少し難しいという現状が明らかになってきました。 なぜ難しいのでしょうか? リモートワーク以前であれば、コミュニケーションを取るために少し社内を歩き回るだけで、お互いに気軽に話しかけやすいという側面がありました。

ですが、リモートワークでは、まずはSlackでの文字でのやりとり、話すためにはMTGの設定をしなければいけなくなりました。リモートワーク以前に入社している人からすれば、相手を見知っているので気軽さはさほど変わらないのかもしれませんが、リモートワーク以降に入社した人もたくさんいます。

チームを越えた仕事が発生した時に初めて、全く知らない人とコミュニケーションを取るのと、少しでも人となりを知っている人とコミュニケーションを取るのでは、違いがあるのではないでしょうか?

その仮説を基に、チーム外の人とのコミュニケーションを促進できるような施策=雑談をしていこう!となりました。

本当に?

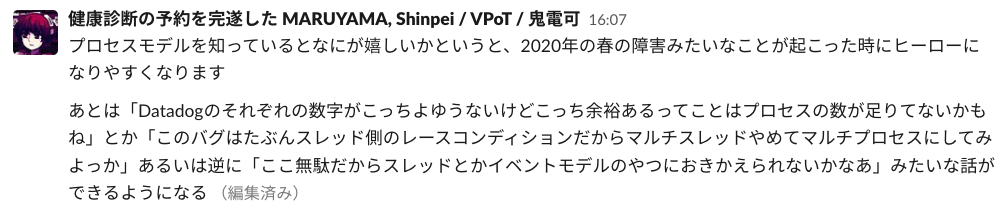

コミュニケーションを取れば、雑談をすれば、本当に課題が全て解決するのでしょうか? そもそも、こういった制度はあまり受け入れられないことも重々承知しています。 なので開発本部の制度として建て付ける際に、それでも意義があると自分自身納得する必要がありました。そんな中、弊社VPoTであるしんぺいさんの記事を読みました。

私には考えもつかない視点で書かれていてとても好きです。上記の文章とともに、弊社のesaの中ではさらに社内の課題を交えた議論がたくさんの人とされていました。

その中で自分が腑に落ちたことは、雑談してもコミュニケーションがうまくいかないことはあるしプロトコルが合わない人もいる。それをもっと早い段階で(仕事で関係性を持つ前に)認識しておく(器官を育てておく)ことが大事なのではないか。そうすれば本番ではもう少し上手くやれるのではないか?ということです。(上手くとは、無闇に衝突しないなど)

そういった事前の場としても機能するのであればやる意義はあるのかな、と思ったのでした。

新しく始めた制度について

新たに「Zatsu談制度」を始めました。名前にあまり深い意味はありません。

この制度の目的は、開発本部内で横の繋がりを作り、チーム外で気軽に話せる人(場)を作ることです。 開発本部内での、弱い関係・斜めの関係を作ることを主目的としています。

弱い関係、斜めの関係ってなんぞや?と思った方は是非上記のリンクを御覧ください。

例えば、同じチーム(強い関係)にしか所属していないと、そのチームにだけ注目してしまい、他のチームから孤立してしまう可能性があります。 考え方・施策・行動など、そのチーム内で個別最適が進むと、いわゆる”サイロ化”が発生します。

「開発本部の課題」にも書いた通り、Classiはサービス(プロダクト)の依存関係が複雑に絡み合った状態で開発されてしまっているため、必然的に外のチームとコラボレーションしながら課題解決に取り組む必要があります。サイロ化した状態ではコラボレーションが進みません。情報伝播や相互理解を促進するためには、弱い関係も必要です。

ちなみに「弱い関係」についてはデメリットもあるそうです。気になる方は「組織デザイン」をご一読ください。

また、斜めの関係性を構築することで、チーム外の関係だからこそ相談できたり、異なる視点を得られたり、新たに別の関係性が生まれたりするのではないでしょうか。

そんな想いでこの制度が立ち上がりました。

Zatsu談制度の運用方法

制度をどのように運用しているかを紹介します。

- Zatsu談制度は、基本は 1on1 形式で行います

- 縛っているわけではないので、他のペアと開催するのでもOKとしています

- ペアの選定仕様は以下となっています

- 誰かの意図・思惑は入れず、ランダムとする

- チーム外の人とペアにする

- 過去にペアになった人と違う人をペアにする

- ペア選定作業はGoogle Apps Script (GAS) で実現しています

- 制度の1実施期間を、3ヶ月に固定しています

- 期間が終了すると、ペアを再選定します

- 一度のZatsu談期間が終わったら、開発本部メンバー全員にアンケート形式でフィードバックをもらいます

- 相談窓口として、Google Formsを用意しています

- 参加が難しいという方もいると思うので、強制はしていません

Zatsu談で何話そう?

突然、雑談してね!と言われても困りませんか?なので色々なZatsu談ネタをesaにまとめて共有しています。

例えば弊社ではチームごとに偏愛マップやモチベーショングラフを作っていたりするので、そのリンクを集めたり、16personalities・Strength finderの結果を共有したりしています。

また、Slackには色々な趣味チャンネルもあるので、そこから話題を広げることもできそうです。

esaには、自己紹介ページを作っている方も多数います。日報を書く方もいて、ペアの日報を読んでいるという方もいました。自分を知ってもらうためには一定の自己開示も大切ですね。

1回目の実施が終わってみて

7月末に1回目のZatsu談期間が終了しました。そのタイミングでアンケートを取ってみたので、一部の内容を紹介します。

Zatsu談回数

- 複数回実施してくださった方が半数以上を占めました

- 1回で終わってしまい続かない方が多いのではないかという予想でしたが、定期的な開催が多く見られました

満足度・目的達成度

1: 不満足 5:満足

1: 不満足 5:満足

1: 達成されてない 5:達成されている

1: 達成されてない 5:達成されている

- まだ制度を始めたばかりなので、もっと左に寄るかなと思いきや、満足度・目的達成共に右に寄っていました。一定の評価をいただけてホッとしました

Zatsu談制度があってよかったこと

制度があってよかったことをたくさんいただいたので、一部を紹介します。

- 直接役立ったり効果があるかはわからないが、Zatsu談ペアになった相手とはちょっと気安い雰囲気は生まれると思う - ペアになった人をハブに、今まで関わったことのない全く知らない人と話す機会を得られました - 知らない部門の人や業務で関わりがない人と話せるのは良い - 会社の歴史のシェアや暗黙知のシェアにもなる - 業務に関係ないプライベートの雑談ができるのが楽しかった! - 普通に人生の先輩として話すだけでも学びがあった! - 合同Zatsu談しているところもあって良いと思った! - 別の領域の人と接点を持てて、その人が別の会で発言されてるのを見ても「Zatsu談で話した人だ!」と顔が浮かんだり、雑談で話したことと紐づいたりして理解が深まった - 普段絡みの無い人と話をすることができた - たまに雑談する間柄だったけど、改めて機会ができてよかったと思う。 - 仕事以外のことを気軽に話せて楽しかった。今後、何かあったときに話しかけるハードルは下がりそう。 - 業務であまり話さない人と話すきっかけが強制的にできるのでよかった。 - 通常業務では関われなかった関係ができた。新卒とペアになったので、他の新卒や研修にも興味を持つようになった。 - 普段話さない内容であったりちょっとした相談を気軽にすることができた。 - 恐らく殆ど接点がなかった&これからも少ないであろう方とお話できたのが嬉しかったです。 - 話すきっかけはできました

この他にも「やってみたら楽しかった!」「Zatsu談制度以外のところでもZatsu談してみた!」「チーム内のコミュニケーションも見直してみた」などの嬉しい声を聞くことができました。

しばらくこの制度を続けてみて、いずれまた状況をこちらで報告したいと思います。

他にやろうとしていること

Classiはサービスもシステムも複雑と何度か書いていますが、その影響もあり中途入社した方は入社当初のキャッチアップに苦労している面も見られます。

中途入社者が組織に適応するまでには一定の期間が必要だと言われています。(組織再社会化) 技術戦略室ではこの点をサポートするべく、中途入社者を受け入れるチームと協力して開発本部のオンボーディングを見直す動きも始めています。

まだまだやりたいこと・やれることはたくさんあるので、引き続きみんながごきげんにミッションを達成できるよう、開発本部の課題を解決していきたいと思っています。